4. Sprechen mit elektronischen Geräten: Rozdźěl mjez wersijomaj

| Rjadka 65: | Rjadka 65: | ||

* Anweisungen werden abgeleitet und ausgeführt (Skill invocation) | * Anweisungen werden abgeleitet und ausgeführt (Skill invocation) | ||

* z. B. [https://wit.ai/ https://wit.ai/] (eine Sprachplattform, welche zum Facebook-Konzern gehört) | * z. B. [https://wit.ai/ https://wit.ai/] (eine Sprachplattform, welche zum Facebook-Konzern gehört) | ||

* z.B. [https://mycroft.ai/ https://mycroft.ai/]als datenschutzfreundliche Alternative | |||

==== Baustein 4: Sprachausgabe (Text to Speech, TTS)<ref name="ftn4">Übersicht TTS-Engines: [https://mycroft-ai.gitbook.io/docs/using-mycroft-ai/customizations/tts-engine https://mycroft-ai.gitbook.io/docs/using-mycroft-ai/customizations/tts-engine]</ref> ==== | ==== Baustein 4: Sprachausgabe (Text to Speech, TTS)<ref name="ftn4">Übersicht TTS-Engines: [https://mycroft-ai.gitbook.io/docs/using-mycroft-ai/customizations/tts-engine https://mycroft-ai.gitbook.io/docs/using-mycroft-ai/customizations/tts-engine]</ref> ==== | ||

Wersija wot 25. apryla 2023, 13:46

Einleitung

Dieser Themenbereich beinhaltet die Unterstützung des Anwenders beim Sprechen mit elektronischen Geräten in den sorbischen Sprachen. Im Fokus steht die Interaktion von Menschen mit elektronischen Geräten mittels gesprochener Worte. Dies umfasst folgende Bereiche:

- Sprachausgabe: das Vorlesen geschriebener sorbischer Wörter

- Spracherkennung: das Erkennen' und Darstellen von gesprochenen sorbischen Wörtern durch elektronische Geräte

- Sprachverarbeitung: das Verarbeiten gesprochener sorbischer Wörter und Reagieren darauf (z. B. Anweisungen ausführen, Antworten).

Mögliche Einsatzbereiche und Applikationen sind bspw.

- Sprachassistenten,

- Spiele, Spielzeuge (wie Lingufino),

- Untertitel und Simultanübersetzungen (z. B. bei Videokonferenzen).

Visionen und Ziel für die sorbische digitale Welt

Vision 2028

Konkrete Visionen 2025

Konkrete Ziele

Einzelne Applikationen verstehen die gesprochenen sorbischen Sprachen und stellen gesprochene Worte dar. (Spracherkennung)

Einzelne Applikationen können sorbische Worte vorlesen. (Sprachausgabe)

Einzelne Applikationen können gesprochene sorbische Worte und Sätze erkennen, verarbeiten und ausgeben, z. B. in einem Online-Videokonferenzsystem mit Simultanübersetzung als Untertitel.

|

Ist-Analyse Stand der Entwicklung von Sprachassistenzsystemen

Welche Bausteine werden für eine Sprachassistenz benötigt?

Sprachassistenzsysteme bestehen aus verschiedenen technischen Bausteinen, die jeweils unterschiedliche Aufgaben übernehmen. Die folgende Einteilung der Bausteine orientiert sich an einem Vortrag von Jan Budar vom 13.09.2018 in Senftenberg zu “Digitalisierung als Chance für die Sorben”.

Baustein 1: Spracherkennung (Automatic Speech Recognition, ASR; Speech to Text, STT)[1]

- basiert auf phonetischen Informationen zu

- einzelnen Buchstaben und Silben

- deren Kombinationen

- ihrer Position im Wort/Satz

- Training von Spracherkennungs-Maschinen:

- Aktuell Deep Learning: Automatische Spracherkennung mit tiefen neuronalen Netzen

- Vorher Hidden-Markov-Modelle: stochastische Modelle, mit denen sprachliche Einheiten (Phoneme oder Wörter) analysiert wurden

- z. B. Mozilla Common Voice[2] in Kombination mit einer Spracherkennungs-Engine wie Mozilla Deep Speech

Baustein 2: Textübersetzung (Machine Translation, MT)

- Grundlage hierfür sind Massen an übersetzten Sätzen

- Künstliche Intelligenz lernt aus diesen übersetzten Sätzen durch

- Mustererkennung

- Training

Baustein 3: Intention erkennen und Anweisungen ausführen[3]

- aus dem erkannten Text wird die Intention des Nutzers extrahiert (intent parser)

- Anweisungen werden abgeleitet und ausgeführt (Skill invocation)

- z. B. https://wit.ai/ (eine Sprachplattform, welche zum Facebook-Konzern gehört)

- z.B. https://mycroft.ai/als datenschutzfreundliche Alternative

Baustein 4: Sprachausgabe (Text to Speech, TTS)[4]

- schon für barrierefreie Webseiten notwendig

- stellt den einfachsten Teil dar

Definition und Marktübersicht von Sprachassistenten

Ein Sprachassistent ist eine bestimmte Art von Software, die gesprochene Worte analysiert, in den richtigen Kontext einordnet und darauf reagiert. Sprachassistenten sind als Software meist in Smartphones oder Smart Speaker, aber auch in Konsolen (PS4), Fernseher und smart watches integriert. Ein Smart Speaker wiederum ist ein bestimmtes Gerät, auf welchem der Sprachassistent als Software installiert ist.[5] Spricht ein Mensch mit diesem Gerät, so beantwortet es über seine Sprachsoftware verbal Fragen oder führt Anweisungen aus, z. B. steuert es vernetzte smart home Geräte (TV-Geräte, Heizungsthermostate, Rollläden, Lampen, Waschmaschine, Backofen, Kaffeemaschine bis hin zur Toilettenspülung usw.). Auch in Autos, Kopfhörern, Bürogeräten und Kleidung sind bereits Sprachassistenten im Einsatz.

Die Entwicklung der Sprachassistenten:* 2010 Apples Siri („Hey Siri“)

- 2012 Google Assistant (vormals Google Now) („Ok, Google“)

- 2013 Microsoft Cortana („Hey Cortana“)

- 2014 Amazon Alexa („Alexa“)

- 2015 Mycroft - open Source Smart Speaker (“Hey Mycroft”)[6]

- 2017 Sprachassistenten der chinesischen Firmen Baidu und Alibaba

- 2018 Samsung Bixby („Hi Bixby“)

- 2019 Leon – open source personal assistant[7]

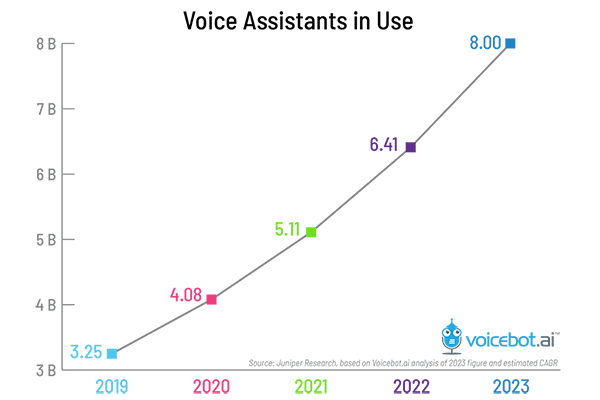

Heute sind weltweit bereits mehr als 4 Milliarden Sprachassistenten im Einsatz. Bis 2023 rechnet die Marktforschungsfirma Juniper Research mit 8 Milliarden Sprachassistenten.[8]

Marktübersicht

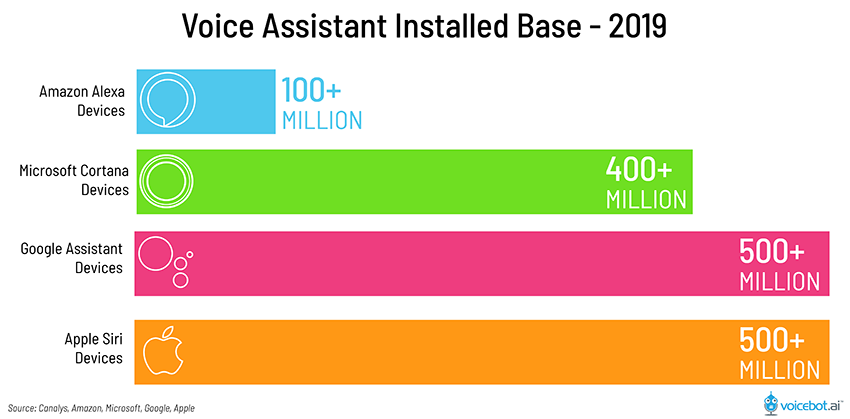

Betrachtet man alle weltweiten Geräte mit Sprachassistenten, dann sind die aktuell am häufigsten installierten Systeme Apples Siri und Google Assistant, gefolgt von Microsoft Cortana und Amazon Alexa.[9]

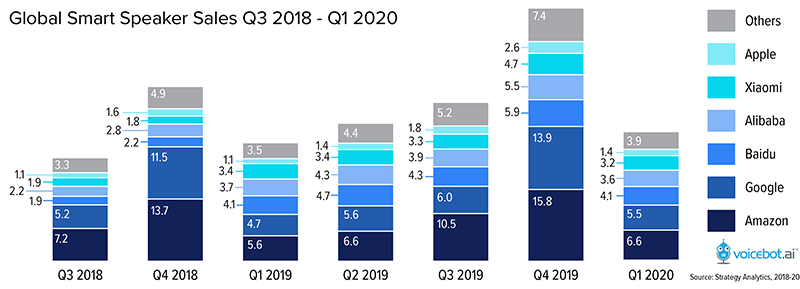

Bei den weltweit verkauften Smart Speakern führt Amazons Alexa die Rangfolge knapp vor Google Assistant.[10] Dabei scheinen Amazons Alexa und Google Assistant zukünftig die wichtigsten Rollen zu spielen, vermutlich aufgrund ihrer Integration von Apps von Drittanbietern.[11] Die Apps für Amazon Alexa werden Skills genannt. Diese lassen sich kostenlos aktivieren und erweitern das Funktionsspektrum des Alexa-Sprachdienstes um bestimmte Fähigkeiten.

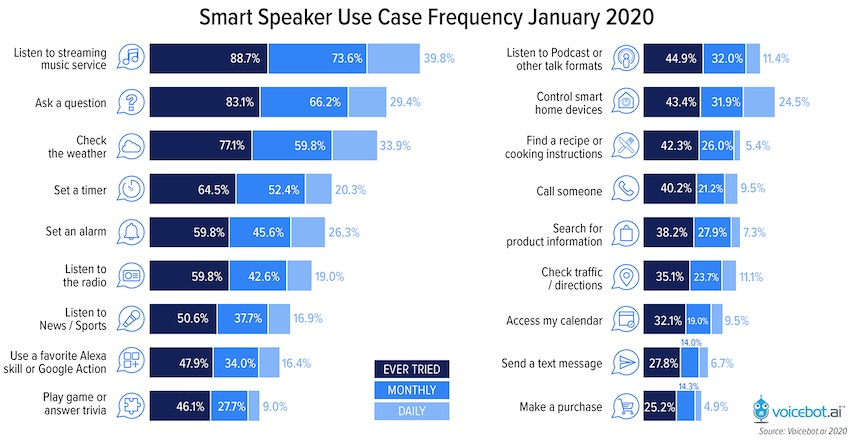

Die beliebtesten Anwendungsfälle von Nutzern von Smart Speakern sind[12]

- Musik hören

- Fragen stellen

- Wetter checken

- Zeitschaltuhr einschalten

- Alarm einstellen

- Radio hören

Aktuell unterstützte Sprachen[13]

- Amazons Alexa unterstützt 8 Sprachen

- Deutsch, Englisch (5 Dialekte), Französisch (2 Dialekte), Hindi (Indisch), Italienisch, Japanisch, Portugiesisch (Brasil.), Spanisch (3 Dialekte)

- Google Assistant unterstützt 44 Sprachen auf Smartphones

- Google Assistant unterstützt 13 Sprachen auf Smart Speakern / Google Home

- Dänisch, Deutsch (2 Dialekte), Englisch (6 Dialekte), Französisch (2 Dialekte), Hindi, Italienisch, Japanisch, Koreanisch, Niederländisch, Norwegisch, Portugiesisch (Brasil.), Schwedisch, Spanisch (3 Dialekte)

- Apples Siri unterstützt 21 Sprachen, zusätzlich zu Google Home:

- Arabisch, Chinesisch, Finnisch, Hebräisch, Malaysisch, Russisch, Thailändisch, Türkisch sowie Dialekte für Chinesisch, Niederländisch, Italienisch

Exkurs Mozilla Common Voice & Deep Speech

Das Ziel von Mozilla Common Voice ist es, Sprachdateien „frei und öffentlich verfügbar“ zu machen und zu vermeiden, dass diese Technologie in den Händen weniger konzentriert ist. Common Voice ist eine globale Datenbank mit gespendeten Stimmen, mit der z. B. sprachgestützte Anwendungen in jeder Sprache trainiert werden können.

Zunächst braucht es eine große Sammlung von urheberrechtsfreien Sätzen, welche dann die Unterstützenden vorlesen können.[14] Anschließend kann das Sammeln von Sprachdaten erfolgen via Crowdsourcing. Insgesamt sind für eine Sprache 10.000 validierte Stunden notwendig (vgl. Englisch hat zum Stand März 2020 ca. 1.200 Stunden).

Die Bewertung der Sprachdaten ist durch jeden Zuhörenden ohne Anmeldung möglich. Der Zuhörende bekommt einen Satz angezeigt und hört eine Audio-Aufnahme des Satzes. Die Qualität der Audio-Aufnahme wird bewertet.

Der fertige Datensatz steht auf der Webseite später via CC0-Lizenz zur Nutzung zur Verfügung. Mozilla bietet hier die Open Source Spracherkennungs-Engine Deep Speech an (diese nutzt Googles TensorFlow), die optimal auf die Verarbeitung der Mozilla Common Voice Daten abgestimmt ist.[15]

Mittels einer Java-Script-API, in der mögliche Use-Cases aufgelistet sind (z. B. Voice Web Search, Speech Command) kann später ein eigener Sprach-Assistent erstellt und in eine App eingebunden werden.

Ist-Analyse sorbischer Potenziale, Ressourcen und Projekte

Während digitale Angebote wie Sprachausgabe und Spracherkennung in deutscher Sprache selbstverständlich sind und sowohl von internationalen Großkonzernen als auch von der öffentlichen Hand vorangetrieben und ausgebaut werden, gilt das für dieselben Angebote in sorbischer Sprache nur sehr eingeschränkt. Welche Grundlagen der Sprachunterstützung beider sorbischer Sprachen bereits realisiert oder geplant sind, sollen die folgenden Abschnitte untersuchen.

Ist-Stand der 4 Bausteine der Sprachassistenz

Baustein 1: Spracherkennung (Automatic Speech Recognition, ASR; Speech to Text, STT)

- sorbische Ausgangslage: Vorarbeiten ansatzweise vorhanden

- Realisierung mittels Mozilla common voice, hierfür sind notwendig:

- Mindestens 5.000 freigeschaltete sorbische Sätze, urheberrechtsfrei, gemeinfrei oder unter Creative-Commons-Lizenz (CC0)[16]

- validierte Sprachaufnahmen von ca. 10.000 Stunden sind notwendig, um ein produktiv einsetzbares Sprache-zu-Text-System zu trainieren

- Was wurde bereits erreicht?

- Sehr engagierte Einzelpersonen sowie die Sächsischen Aufbau- und Erprobungskanäle (SAEK) treiben die Sammlung von freien Sprachdateien in Mozilla common voice voran

- die Webseiten-Lokalisierung für Ober- und Niedersorbisch sind zu 100% abgeschlossen (https://voice.mozilla.org/hsb und https://voice.mozilla.org/dsb)

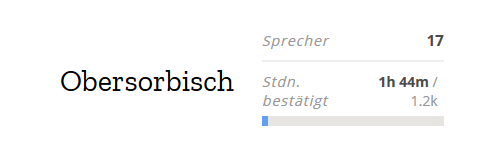

- für das Obersorbische wurden bereits ca. 7.000 lizenzfreie Sätze gesammelt sowie 1 Stunde und 44 Minuten eingesprochen und validiert (ca. 0,017%)

- diese sind aktuell in sehr unterschiedlicher Qualität, sehr unausgewogen hinsichtlich der Stimmen (Geschlecht- und Alter-Verteilung)

- darüber hinaus lassen sich die Sätze common voice aktuell nicht thematisch zuordnen

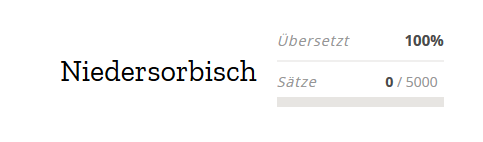

- Für das Niedersorbische fehlen die Sätze und das Einsprechen[17]

- Die folgenden Grafiken zeigen den aktuellen Stand der sorbischen Sprachen in Mozilla common voice:

- 2020 startete das Projekt „Spracherkennung und maschinelle Übersetzung der sorbischen Sprachen“ der Stiftung für das sorbische Volk

- Geplant ist eine Machbarkeitsstudie zur automatischen Spracherkennung für die obersorbische Sprache vom Fraunhofer-Institut für keramische Technologien und Systeme Dresden (Abteilung Maschinelles Lernen und Datenanalyse) in Zusammenarbeit mit der Brandenburgischen Technischen Universität Cottbus mit folgenden Zielstellungen:

- Realisierung eines prototypischen Spracherkenners für eine spezifizierte Beispielanwendung in einer stark beschränkten Sprachdomäne

- Einschätzung möglicher und empfohlener Technologien für die Entwicklung eines sorbischen Spracherkenners mit umfangreichem Wortschatz

- Aussagen zur Anwendung der niedersorbischen Sprache

- Es wurden bereits erste Arbeitsschritte für dieses Projekt durchgeführt.

- Geplant ist eine Machbarkeitsstudie zur automatischen Spracherkennung für die obersorbische Sprache vom Fraunhofer-Institut für keramische Technologien und Systeme Dresden (Abteilung Maschinelles Lernen und Datenanalyse) in Zusammenarbeit mit der Brandenburgischen Technischen Universität Cottbus mit folgenden Zielstellungen:

Baustein 2: Textübersetzung (Machine Translation, MT)

- Notwendig: umfangreicher 2-sprachiger Textkorpus

- Urheberrechtsfrei, gemeinfrei oder unter Creative-Commons-Lizenz (CC0)

- Satzweise übersetzt

- Vereinheitlicht, maschinenlesbar

- Sorbische Ausgangslage: eher kleiner paralleler Textkorpus liegt im WITAJ-Sprachzentrum vor

- Aufgabe: laufende digitale Erfassung bestehender Übersetzungen in hoher Qualität

- Herausforderung: Technologieneutralität, d. h. eine Textübersetzung unabhängig von einer speziellen Technologie zu erstellen, so dass sie später in verschiedenen Produkten und Diensten genutzt werden kann (Google Translate, Microsoft Bing Translator, DeepL)

- Seit 2019 laufendes Projekt des WITAJ-Sprachzentrums: Aufbau eines automatischen „Online-Übersetzers Deutsch-Sorbisch, Sorbisch-Deutsch“ zunächst für Obersorbisch, später auch Niedersorbisch

- Aufbau eines großen 2-sprachigen Textkorpus, Ziel bis Ende 2020 ca. 170.000 Satzpaare (ca. 2 Mio. Wörter)

- das Projekt startete mit dem Tool Microsoft Translator Hub (eingestellt durch Microsoft)

- es wird nun der Ansatz verfolgt, offene Plattformen zu nutzen, um Unabhängigkeit von den Firmen Google, Microsoft, DeepL usw. und deren wirtschaftlichen Interessen zu bewahren

- aktuell wird das statistische System MOSES-decoder genutzt

- parallel erfolgen Test des neuronalen Systems OpenNMT (Python)

- für März 2021 ist eine erste öffentlich zugänglichen Test-Version geplant, die weiterentwickelt werden soll

Baustein 3: Intention erkennen und Anweisungen ausführen

- Hierzu sind keine sorbischen Projekte bekannt. Es kann zu einem späteren Zeitpunkt im Bedarfsfall ggf. auf bereits bestehende Projekte zurückgegriffen werden, wie z. B. https://wit.ai/.

Baustein 4: Sprachausgabe (Text to Speech, TTS)

Erste Projekte in die Richtung Sprachausgabe wurden bereits umgesetzt:

- Audioversion des Deutsch-Niedersorbischen Wörterbuchs (nicht als TTS realisiert)

- Für die niedersorbische Sprache wurden vom Sorbischen Institut seit 2014 Tondateien erstellt und in die online-Fassung des Deutsch-Niedersorbischen Wörterbuchs integriert. In einer wissenschaftlichen Studie wurden zudem die verschiedenen Erfahrungen mit praktischen Schwierigkeiten bei der Aussprache verarbeitet. Diese Studie diente dazu, im Jahre 2018 einen praktischen online-Führer zur Aussprache des Niedersorbischen zu erarbeiten. Hochwertige Tonaufnahmen wurden zusammengestellt und bestimmten Lautgruppen bzw. für den Spracherwerb wichtigen lautlichen Phänomenen zugeordnet, mit wichtigen erläuternden Texten ergänzt und auf www.dolnoserbski.de als neue Dienstleistung angeboten. Dadurch steht erstmals eine praktische, durch Tonbeispiele illustrierte Anleitung zur Aussprache des Niedersorbischen zur Verfügung.

- Entwicklung einer Vorlesefunktion für die nieder- und obersorbische Schriftsprache

- Seit 2018 erfolgen die Konzeption, Planung und Entwicklung einer Vorlesesoftware für Nieder- und Obersorbisch für die Integration in Webseiten, Online-Wörterbücher u. ä. durch das Sorbische Institut in Bautzen. Geplanter Abschluss ist 2023.

Fazit

Für eine funktionierende Spracherkennung der sorbischen Sprachen ist es noch ein weiter Weg, auf dem die ersten Schritte bereits gegangen wurden. Eine breite Basis an digitalen Wortsammlungen (sog. linguistischen Ressourcen) in Form von Wörterbüchern, Textkorpora sowie entsprechende morphologische Generatoren sind für beide sorbische Sprachen vorhanden, vgl. Kapitel 5. Schreiben auf elektronischen Geräten. Hierfür sind noch die Nutzungsrechte zu klären, vgl. Kapitel 10. Open Access, Open Data, Lizenzen.

Für die hierauf aufbauenden digitalen sorbischen Sprachdienste werden aktuell gerade erst die Grundlagen gelegt oder eruiert. Für die Umsetzung einer Spracherkennung laufen aktuell 2 Projekte: das freiwillige Projekt der Sammlung von Sprachdaten mittels Mozilla common voice sowie das Projekt „Spracherkennung und maschinelle Übersetzung der sorbischen Sprachen“ der Stiftung für das sorbische Volk.

Für die Umsetzung einer automatischen Textübersetzung gibt es das Projekt „Online-Übersetzer Deutsch-Sorbisch, Sorbisch-Deutsch“ des WITAJ-Sprachzentrums. Dieses bezieht sich aktuell zunächst auf obersorbische Texte.

Für den Baustein 3 „Intention erkennen, Anweisungen ausführen“ gibt es keine speziellen sorbischen Projekte, jedoch eine Reihe weltweiter Projekte, einige davon open source. Sind die weiteren Bausteine realisiert, so kann ein passendes System für die Umsetzung dieses Bausteins recherchiert werden.

Für die Sprachausgabe entwickelt das Sorbische Institut bereits eine Vorlesefunktion für beide sorbischen Sprachen, welche voraussichtlich 2023 abgeschlossen ist. Ebenso werden vom Sorbischen Institut die niedersorbischen Online-Wörterbücher nach und nach mit Tonbeispielen unterlegt. Für das Niedersorbische sind hierfür bereits umfangreiche Tonbeispiele zur Aussprache des Niedersorbischen auf www.dolnoserbski.de veröffentlicht.

Übersicht von bisherigen Maßnahmen und Projekten bzgl. Sprachassistenz

Weitere Projekte zu Wörterbüchern u. ä. werden in Abschnitt 5.3.2 "Übersicht von bisherigen Maßnahmen und Projekten bzgl. Schreibunterstützung" genannt.

| Name | Beschreibung | Zeitraum | Verantwortlich |

| Audioversion des Deutsch-Niedersorbischen Wörterbuchs | Tonbeispiele zur Aussprache des Niedersorbischen | Seit 2014 | Sorbisches Institut |

| Erarbeitung eines online-Führers mit Tonbeispielen zur Aussprache des Niedersorbischen | Veröffentlichung auf www.dolnoserbski.de | 2018 | Sorbisches Institut, gefördert durch die Stiftung für das sorbische Volk |

| Entwicklung einer Vorlesefunktion für die nieder- und obersorbische Schriftsprache[18] | Konzeption, Planung und Entwicklung einer Vorlesesoftware für Nieder- und Obersorbisch (geplanter Abschluss 2023) | Seit 2018 | Sorbisches Institut, gefördert durch das Sächsische Staatsministerium für Wissenschaft, Kultur und Tourismus (SMWT) |

| Online-Übersetzer Deutsch-Sorbisch, Sorbisch-Deutsch

(zunächst Obersorbisch) |

Entwicklung und Bereitstellung eines Online-Übersetzers für Sätze und Texte, Deutsch-Sorbisch und Sorbisch-Deutsch. Als Übersetzungsgrundlage dient ein bilingualer Textkorpus, welcher erstellt wird und für das Training eines Übersetzungssystems verwendet wird. | Seit 2019 | WITAJ-Sprachzentrum, gefördert durch die Stiftung für das sorbische Volk |

| Mozilla Common Voice obersorbisch und niedersorbisch | Erstellung von öffentlich zugänglichen Sprachdaten, diese stehen via CC0-Lizenz zur freien Nutzung zur Verfügung, z. B. für das Training eine Spracherkennungs-Engine | Seit 2019 | engagierte Einzelpersonen |

| Spracherkennung und maschinelle Übersetzung der sorbischen Sprachen | Machbarkeitsstudie zur automatischen Spracherkennung für die obersorbische Sprache | Seit 2020 | Stiftung für das sorbische Volk |

Zukünftige Maßnahmen und Projekte bzgl. Sprachassistenz

Die folgenden Maßnahmen ergeben sich aus der Ist-Analyse. Sie werden in Abschnitt 13.2 beschrieben.

| Sub-Thema | Nr. | Maßnahme | Zielstellung: |

| Spracherkennung | 1.1_1 | Entwicklung einer obersorbischer Spracherkennung (HSB) | Die obersorbische Spracherkennung ist auf den meistgenutzten elektronischen Geräten nutzbar. |

| Spracherkennung | 1.1_2 | Entwicklung einer niedersorbischer Spracherkennung (DSB) | Die niedersorbische Spracherkennung ist auf den meistgenutzten elektronischen Geräten nutzbar. |

| Übersetzungsdienst | 1.1_3 | Entwicklung obersorbischer Übersetzungsdienst (für Sätze) (HSB) | Ein obersorbischer Übersetzungsdienst ist auf den meistgenutzten elektronischen Geräten nutzbar. |

| Übersetzungsdienst | 1.1_4 | Entwicklung niedersorbischer Übersetzungsdienst (für Sätze) (DSB) | Ein niedersorbischer Übersetzungsdienst ist auf den meistgenutzten elektronischen Geräten nutzbar. |

| Sprachausgabe | 1.1_5 und 1.1_6 | Entwicklung einer Sprachausgabe (HSB, DSB) | Eine Sprachausgabe in beiden sorbischen Sprachen ist auf den meistgenutzten elektronischen Geräten nutzbar. |

| Intention und Anweisungen | 1.1_7 | Finden einer Software für 'Intention und Anweisungen' | Für die Interaktion mit elektronischen Geräten kann die gesprochene sorbische Sprache gleichwertig zur geschriebenen Sprache genutzt werden. |

- ↑ Übersicht STT-Engines: https://mycroft-ai.gitbook.io/docs/using-mycroft-ai/customizations/stt-engine

- ↑ vgl. https://voice.mozilla.org und https://github.com/mozilla/DeepSpeech

- ↑ vgl. https://mycroft.ai/wp-content/uploads/2018/08/mycroft-ai-introduction-to-voice-stack-whitepaper.pdf

- ↑ Übersicht TTS-Engines: https://mycroft-ai.gitbook.io/docs/using-mycroft-ai/customizations/tts-engine

- ↑ vgl. https://de.wikipedia.org/wiki/Intelligenter_pers%C3%B6nlicher_Assistent

- ↑ vgl. https://mycroft.ai/ und https://www.kickstarter.com/projects/aiforeveryone/mycroft-an-open-source-artificial-intelligence-for/description

- ↑ vgl. https://getleon.ai/

- ↑ vgl. https://voicebot.ai/google-home-google-assistant-stats/#voice-asst-in-use-juniper

- ↑ vgl. https://voicebot.ai/2019/01/06/amazon-alexa-is-available-on-100-million-devices-heres-why-it-is-actually-more-and-how-it-stacks-up-against-apple-and-google/

- ↑ vgl. https://voicebot.ai/2020/05/25/global-smart-speaker-growth-cools-in-q1-as-pandemic-leads-to-declining-china-sales-amazon-retains-top-spot-says-strategy-analytics/

- ↑ vgl. https://voicebot.ai/2020/05/11/voice-industry-professionals-say-amazon-alexa-is-having-the-biggest-impact-followed-by-google-with-everyone-else-far-behind-new-report/

- ↑ vgl. https://voicebot.ai/2020/05/03/streaming-music-questions-weather-timers-and-alarms-remain-smart-speaker-killer-apps-third-party-voice-app-usage-not-growing/

- ↑ vgl. https://www.globalme.net/blog/language-support-voice-assistants-compared/ sowie die dort angegeben Webseiten

- ↑ vgl. https://common-voice.github.io/sentence-collector/#/

- ↑ vgl. https://github.com/mozilla/DeepSpeech

- ↑ vgl. https://common-voice.github.io/sentence-collector/#/

- ↑ vgl. https://voice.mozilla.org/de/languages

- ↑ vgl. https://www.serbski-institut.de/de/Entwicklung-einer-Vorlesefunktion-fuer-die-nieder--und-obersorbische-Schriftsprache/